在当下,数字计算机于处理像是图像识别、自然语言理解这类认知任务之时,其功耗能够达到数百瓦,然而人脑仅仅只需20瓦就可以轻松地完成这些任务。

这种存在着巨大能效差异之处,正促使科学家们,从中从脑科学里去获取灵感,进而重新开展设计计算硬件的工作,最终催生出了神经形态计算这一处于前沿位置的领域。

从大脑结构重塑计算范式

人脑之中,含有大约1000亿个神经元,还有千万亿个突触,它们共同构成了一个处于动态变化,能够可重构的复杂系统。

在大脑里头,神经元身为处理器,突触直接担当存储器功能,这两者在物理方面紧密耦合。

这种结构让大脑能在极低功耗下,利用集体行为进行复杂计算。

与之形成对照的是传统电子计算机,内存和处理器处于被物理分离的状态,数据是在冯·诺依曼瓶颈里来回进行传输的。

2020年,有一篇在《自然》杂志上发表的文章表明,当这种架构执行认知任务时,数据搬运的过程耗费了大量能量,进而成为了效率提升的根本阻碍。

汲取灵感的两种路径

当前神经形态计算研究呈现出两条清晰的路径。

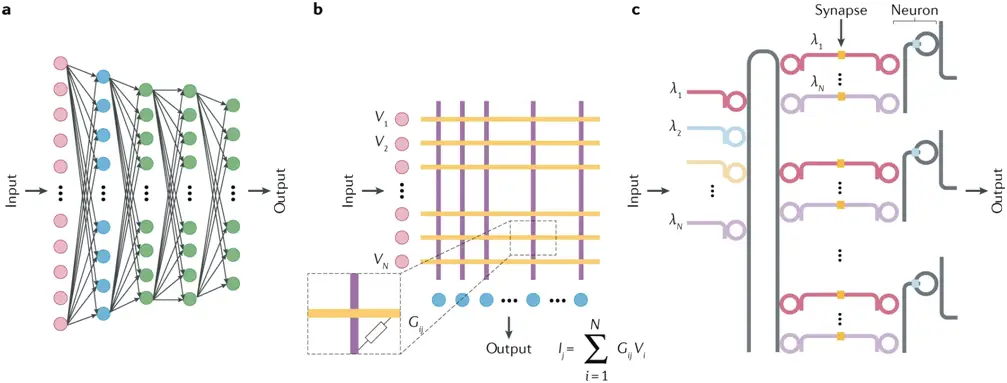

第一条,从人工智能领域获取灵感,其目的在于,把现有的深度神经网络算法,也就是如图2所展示的卷积网络,映射到专用物理硬件之上,进而提升其运行能效。

这种方法的优势在于能快速落地现有成熟算法。

第二条路径则更为根本,它直接从神经科学中寻求答案。

研究人员尝试去模仿生物神经元具备着的复杂动力学特性,并非只是单单把它化简成为输入跟那么输出的非线性函数。

针对这种方法,期望给人工网络配备更为丰富的特征,借此达成超越当下AI的复杂计算能力。

物理与材料的基石作用

实现神经形态计算的关键在于物理和材料科学的突破。

经过研究显示得出这样的结论,唯有去创造出人工纳米神经元以及突触,并且把它们予以大规模的互联操作,才能够在物理层面去复现大脑的拓扑结构。

这需要开发能够模拟生物突触可塑性的新材料。

例如,混合CMOS/忆阻系统便是重要尝试。

当中呢,神经元是由传统模拟或者数字电路给构成的,然而忆阻器却是当作物理突触,是以非易失性的方式在原地去存储权重的。

这种设计极大程度降低了数据于电路内的移动,于物理底层为速度以及能效的提高奠定了根基。

深度网络的硬件映射方案

以当下应用最为广泛的深度网络为对象,在学术领域里面,已经有人提出了两种具备可扩展性的物理架构。

一种是混合的CMOS与忆阻系统,信息在模拟或者数字神经元那里,以电流形式,往忆阻突触间流动。

这种架构,能以高效的方式,去执行深度网络的矩阵运算,它是当前的一个方向,且是商业化潜力较高的那种方向。

另一种引人瞩目的方案是光子神经网络。

它借助光速开展计算,经由克尔效应达成非线性功能,或者凭借半导体激光器里的载流子加热达成非线性功能。

光子系统具备极高的带宽,其能够天然地避免电阻热损耗,这为达成超高速的神经网络推理提供了全新可能,同时也为实现低延迟的神经网络推理提供了全新可能。

挑战与前景并存的未来

尽管前景广阔,神经形态计算仍面临严峻挑战。

于设备这一层面而言,不知怎样去达成每个神经元超出1000个突触的那种高密度互连状态,且要使之趋近大脑的水平,这成为了材料科学当中的一个极大难题。

与此同时,纳米器件所具备的固有的可变性,以及其存在的不可靠性,同样对算法设计提出了新的要求。

算法方面,那些从事研究工作的人员在致力于创造出,经由物理器件所具备的缺陷来开展学习成效的全新算法。

大脑具备借助不完美且随机的生物组件实现高效学习的能力,这一情况给予我们启示,或许我们不应该去追求那种完美的硬件一致性,而是要去开发一种新型计算范式,这种范式得能够适应甚至利用此种非理想特性。

从玩具系统到大规模网络

目前,许多突破性进展源于小型物理神经形态系统的搭建。

比如,存在这样一个研究团队,他们研发出了一种实验性玩具网络,而该网络的构成元素包含自旋电子纳米振荡器,这些自旋电子纳米振荡器充当着神经元的角色。

这些规模受限的小型系统,却为验证理论假设构造了宝贵的实验平台,且为探索物理现象搭建了宝贵的实验平台。

最终要达成的宏伟目标,是去构建大规模系统,该系统包含数百万个组件,而这需要物理学、材料科学以及纳米技术协同进行创新。

这一目标得以实现,意味着在系统层面要达成趋近大脑的互连密度,与此同时,要去开发全新的学习算法,以此来处理海量纳米器件的集体行为。

处于多学科交叉爆发点的神经形态计算,未来到底是哪种材料会成为主流,哪种物理原理又会成为主流呢?

是硅基CMOS、忆阻器还是光子芯片?

你认为在迈向类脑智能的道路上,最大的技术瓶颈是什么?

欢欢喜喜地在评论区域去分享你那独特的见解,为这篇文章点一个大大的赞,跟更多数位的朋友一块儿去探讨有关计算的将来。

Comments NOTHING